Nel corso del Siggraph 2017 di Los Angeles un gruppo di lavoro del MIT (Massachusetts Institute of Technology), in collaborazione con Adobe e altre realtà, ha mostrato una tecnologia interessante riguardante la smartphone photography. Cerchiamo prima di capire si cosa si tratta e che problemi intende risolvere.

Esistono da tempo tecnologie che possono farci vedere l'anteprima di una fotografia in seguito ad una eventuale post-produzione, basti pensare ai numerosi plug-in di Photoshop e non solo per inquadrare ciò di cui stiamo parlando. Problema: sono operazioni complesse che richiedono una grande potenza elaborativa, che possiamo definire proibitiva per gli smartphone. Non solo: ciò avviene partendo da foto in archivio, quindi con un'immagine fatta e finita già esistente.

Ebbene, il gruppo di lavoro del MIT ha realizzato qualcosa di davvero interessante: un algoritmo particolare fornisce l'anteprima in tempo reale di come sarà l'immagine con la post produzione, prima dello scatto, il tutto su smartphone. Oltre al risultato finale risulta interessante capire come siano riusciti a superare alcuni problemi davvero spinosi, come la potenza elaborativa necessaria per l'anteprima in tempo reale, così come per tutto il meccanismo di machine learning che ci sta dietro.

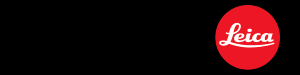

Cerchiamo si semplificare un discorso molto più complesso (in fondo includiamo anche un video). L'algoritmo agisce su diversi livelli, partendo da un input (di fatto ciò che si inquadra, non esistendo ancora la fotografia). L'analisi in tempo reale della scena avviene prima di tutto su una versione a bassa risoluzione dell'input: in questo caso bastano e avanzano le potenzialità computazionali degli smartphone, utili a trasformare in matrici e stringhe dal basso "peso" computazionale molti parametri per determinare la scena. Il software prevede migliaia di "scene" già in memoria, ma dal peso in MB irrisorio, poiché già trasformate a monte per creare uno storico utilizzabile come confronto.

Al MIT insomma hanno lavorato mettendo a confronto immagini ad alta risoluzione prima e dopo la post-produzione, creando un archivio successivamente integrato nella app utilizzata come esempio, realizzato con parametri facilmente elaborabili.

Non finisce qui però: l'input viene contemporaneamente "mappato" in bianco e nero per salvare dettagli che di solito si perdono nelle anteprime a bassa risoluzione. A questo punto il software è pronto per mettere a confronto la scena con quelle in archivio, tenendo presente anche l'anteprima in bianco e nero, restituendo a schermo e in tempo reale la scena già post-prodotta ritenuta più adatta in base allo storico, ma anche a quelle scattate sullo smartphone in precedenza (ecco perché si parla anche di machine learning).

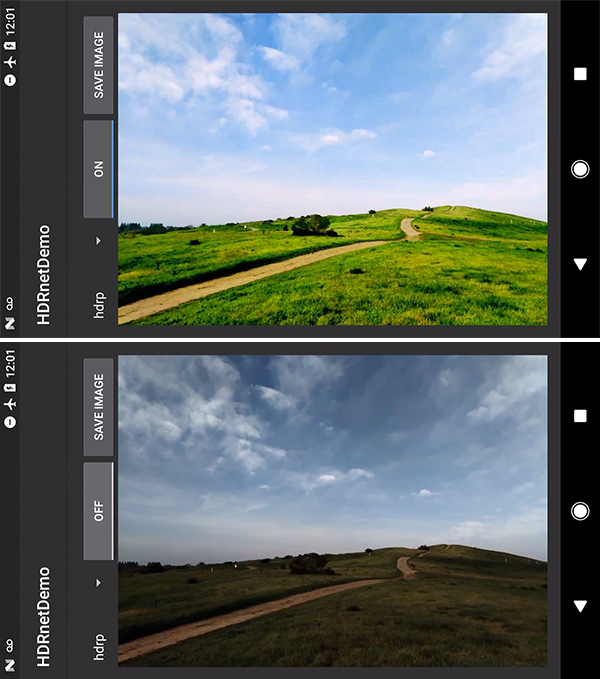

Ecco come appare sul display: lo screenshot superiore mostra l'anteprima, sotto con la funzionalità disabilitata. Un progetto che riteniamo interessante (molto più di quello segnalato ieri sul Computational Zoom), ora non resta che attendere per vedere se sarà una funzionalità prevista su qualche smartphone o disponibile attraverso una specifica app.